Může umělá inteligence kolabovat? Odborníci varují před jejími nebezpečími a řešeními

Proč může generativní AI sebedestruovat? Objevte nedávné studie, které varují před její degradací, a odborníky, kteří analyzují možné řešení....

Obsah

- Alarm degradace v generativní IA

- Kolaps modelu: degenerativní fenomén

- Těžkost lidské intervence

- Budoucnost nejistoty: Výzvy a možné řešení

Alarm degradace v generativní IA

Recentní studie spustily alarmy ohledně znepokojivého fenoménu v rozvoji generativní umělé inteligence: degradace kvality odpovědí.

Odborníci upozornili, že když jsou tyto systémy trénovány s pomocí syntetických dat, tedy obsahu generovaného jinými AI, mohou se dostat do cyklu zhoršování, který vyústí v absurdní a nesmyslné odpovědi.

Otázka, která vyvstává, je: jak se k tomuto bodu dostáváme a jaká opatření lze přijmout, abychom tomu předešli?

El "kolaps modelu" se vztahuje na proces, ve kterém se systémy umělé inteligence ocitají v cyklu trénování s nekvalitními daty, což vede ke ztrátě rozmanitosti a efektivity.

Kolaps modelu: degenerativní fenomén

El "kolaps modelu" se vztahuje na proces, ve kterém se systémy umělé inteligence ocitají v cyklu trénování s nekvalitními daty, což vede ke ztrátě rozmanitosti a efektivity.

Podle Ilie Shumailova, spoluautora studie publikované v časopise Nature, tento fenomén nastává, když se umělá inteligence začne živit svými vlastními výstupy, což perpetuuje zaujatosti a snižuje její užitečnost. V dlouhodobém horizontu to může vést k tomu, že model produkuje stále homogennější a méně přesný obsah, jako ozvěnu svých vlastních odpovědí.

Emily Wenger, profesorka inženýrství na Duke University, ilustruje tento problém jednoduchým příkladem: pokud se umělá inteligence trénuje na generování obrázků psů, bude mít tendenci replikovat nejběžnější plemena a opomíjet méně známá.

Emily Wenger, profesorka inženýrství na Duke University, ilustruje tento problém jednoduchým příkladem: pokud se umělá inteligence trénuje na generování obrázků psů, bude mít tendenci replikovat nejběžnější plemena a opomíjet méně známá.

Toto není pouze odraz kvality dat, ale také představuje významná rizika pro zastoupení menšin v tréninkových datech.

Čtěte také: Umělá inteligence je stále chytřejší a lidé stále hloupější.

Ačkoli je situace vážná, řešení není jednoduché. Shumailov uvádí, že není jasné, jak předejít kolapsu modelu, ačkoli existují důkazy, že míchání reálných dat se syntetickými může zmírnit efekt.

Čtěte také: Umělá inteligence je stále chytřejší a lidé stále hloupější.

Těžkost lidské intervence

Ačkoli je situace vážná, řešení není jednoduché. Shumailov uvádí, že není jasné, jak předejít kolapsu modelu, ačkoli existují důkazy, že míchání reálných dat se syntetickými může zmírnit efekt.

Nicméně to také znamená zvýšení nákladů na trénink a větší obtíže při přístupu k úplným datovým sadám.

Absence jasného přístupu k lidské intervenci ponechává vývojáře před dilematem: mohou lidé skutečně kontrolovat budoucnost generativní AI?

Fredi Vivas, CEO společnosti RockingData, varuje, že nadměrný trénink s syntetickými daty může vytvořit "efekt ozvěny", kde se AI učí ze svých vlastních nepřesností, což ještě více snižuje její schopnost generovat přesný a rozmanitý obsah. Tak se otázka, jak zajistit kvalitu a užitečnost modelů AI, stává stále naléhavější.

Budoucnost nejistoty: Výzvy a možné řešení

Experti se shodují na tom, že používání syntetických dat není inherentně negativní, ale jejich správa vyžaduje odpovědný přístup. Návrhy jako implementace vodoznaků do generovaných dat by mohly pomoci identifikovat a filtrovat syntetický obsah, čímž by se zajistila kvalita při trénování modelů AI.

Efektivita těchto opatření však závisí na spolupráci mezi velkými technologickými společnostmi a menšími vývojáři modelů.

Budoucnost generativní AI je v sázce a vědecká komunita se nachází v závodu s časem, aby našla řešení, než bublina syntetického obsahu praskne.

Budoucnost generativní AI je v sázce a vědecká komunita se nachází v závodu s časem, aby našla řešení, než bublina syntetického obsahu praskne.

Klíčem bude vytvoření robustních mechanismů, které zajistí, že modely AI zůstanou užitečné a přesné, a tím se předejde kolapsu, kterého se mnozí obávají.

Přihlaste se k odběru bezplatného týdenního horoskopu

Beran Blíženců Býk Kozoroh Lva Panna Rak Ryby Štír Střelce Vah Vodnář

-

Neuvěřitelný příběh milionáře sežraného kanibaly

Neuvěřitelný příběh milionáře sežraného kanibaly

Tajemství Michaela Rockefellera: mladý fotograf, který opustil New York, aby žil s kanibaly, a v roce 1961 zmizel v pralese Nové Guineje. -

Video: majitel tohoto auta má skutečný problém se včelami

Video: majitel tohoto auta má skutečný problém se včelami

Majitel vozu, kterého můžeme vidět na tomto videu, se setkal s opravdovým problémem: nebezpečné včely tam postavily svůj úl. -

Syndrom cizího přízvuku, co to způsobuje a jak to ovlivňuje řeč

Syndrom cizího přízvuku, co to způsobuje a jak to ovlivňuje řeč

Objevte záhadný syndrom cizího akcentu: vzácná porucha, která odhaluje fascinující spojení mezi mozkem a jazykem. -

Rádiový přenos, který vyvolal paniku z útoku mimozemšťanů

Rádiový přenos, který vyvolal paniku z útoku mimozemšťanů

Objevte, jak Orson Welles vyvolal paniku svou rozhlasovou adaptací 'Válka světů' 30. října 1938 a revolucionalizoval média. -

Yuval Noah Harari debatuje o AI a nebezpečích ve své nové knize

Yuval Noah Harari debatuje o AI a nebezpečích ve své nové knize

Yuval Noah Harari ve své nové knize 'Nexus' varuje před umělou inteligencí: mocnější než Hitler a Stalin, ohrožuje soukromí a naše sociální struktury. Přečtěte si více!

Jsem Patricia Alegsa

Již více než 20 let se profesionálně věnuji psaní horoskopů a svépomocných článků.

Přihlaste se k odběru bezplatného týdenního horoskopu

Získejte každý týden ve svém e -mailu horoskop a naše nové články o lásce, rodině, práci, snech a dalších zprávách. Neposíláme spam.

Astrální a numerologická analýza

-

Online vykladač snů: s umělou inteligencí

Chcete vědět, co znamená nějaký sen, který jste měli? Objevte sílu porozumění vašim snům s naším pokročilým online výkladem snů pomocí umělé inteligence, která vám odpoví během vteřin.

Online vykladač snů: s umělou inteligencí

Chcete vědět, co znamená nějaký sen, který jste měli? Objevte sílu porozumění vašim snům s naším pokročilým online výkladem snů pomocí umělé inteligence, která vám odpoví během vteřin.

-

Revoluční terapie pro hormonální deficit: případ Messi

Revoluční terapie pro hormonální deficit: případ Messi

Objevte inovativní diagnostiku Lea Messiho ve 19 letech a novou terapii, která by mohla revolučně změnit léčbu deficitu somatropinu. -

Neuvěřitelné! V Egyptě byla nalezena meč Ramsese II, který září po 3 000 letech

Neuvěřitelné! V Egyptě byla nalezena meč Ramsese II, který září po 3 000 letech

V Egyptě byla objevena meč Ramsese II, který září po 3 000 letech. Úžasný nález ve starobylé pevnosti v deltě Nilu! -

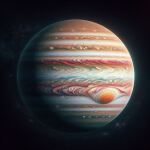

Velká červená skvrna na Jupiteru se zmenšuje a už víme proč

Velká červená skvrna na Jupiteru se zmenšuje a už víme proč

Objevte neuvěřitelnou kosmickou bouři, kterou jsme pozorovali po desetiletí na Jupiteru. Rozluštili jsme tajemství její kontrakce. Prozkoumejte kosmos s námi! -

Sbohem, ďábelská rybo! Zemřela abysální bytost, která překvapila svět

Sbohem, ďábelská rybo! Zemřela abysální bytost, která překvapila svět

Černý ďáblův ryb, vzácný návštěvník Kanárských ostrovů, umírá za jasného dne. Nyní leží v Přírodovědném muzeu na Tenerife, připraven k prozkoumání. -

Mohou vaše klouby předpovědět déšť? Věda se vyjadřuje

Mohou vaše klouby předpovědět déšť? Věda se vyjadřuje

Bolest kloubů jako detector bouří? Klouby mohou předpovědět déšť. Věda nebo mýtus? Tlak a cvičení by mohly mít odpověď. ?️? -

Podivný objev na Marsu, skála, která překvapila NASA

Podivný objev na Marsu, skála, která překvapila NASA

Podivný objev na Marsu: Perseverance objevuje skálu s pruhy jako zebra, což vzbuzuje zájem vědců a nové teorie v kráteru Jezero. -

Proč aerosolové insekticidy selhávají proti švábům?

Proč aerosolové insekticidy selhávají proti švábům?

Aerosolové insekticidy neodstraní všechny šváby, zejména německé. Vědci z Kentucky a Auburn zdůrazňují potřebu nových kontrolních strategií. -

Nejvíce manipulativní věci, které dělají jednotlivá znamení zvěrokruhu

Nejvíce manipulativní věci, které dělají jednotlivá znamení zvěrokruhu

Každý má schopnost manipulovat s ostatními, aby získal věci, které chce. Možná si neuvědomujete, že s někým manipulujete, nebo přesně víte, co děláte. -

Vstaň z křesla! Jak sedavé chování ovlivňuje tvé srdce

Vstaň z křesla! Jak sedavé chování ovlivňuje tvé srdce

Sedění příliš dlouho stárne srdce, i když cvičíte. Objevte, jak tento negativní efekt zvrátit. -

Emocionální nezralost: skrytý nepřítel, který sabotuje vaše vztahy a profesionální úspěch

Emocionální nezralost: skrytý nepřítel, který sabotuje vaše vztahy a profesionální úspěch

Emocionální nezralost, neviditelná překážka, ovlivňuje vztahy a pracovní výkon. Její identifikace je klíčová pro přerušení cyklů viktimizace a autentický růst. -

Co znamená snít o cigaretách?

Co znamená snít o cigaretách?

Objevte význam snů o cigaretách. Tento článek se zabývá symbolikou kouře a tabáku ve vašich snech a jejich vlivem na váš každodenní život. -

Najděte slova povzbuzení pro své hvězdné znamení

Najděte slova povzbuzení pro své hvězdné znamení

Objevte slova, která potřebujete podle svého znamení zvěrokruhu - využijte sílu hvězd ve svém životě! -

Jak myslíme, ovlivňuje vnímání plynutí času

Jak myslíme, ovlivňuje vnímání plynutí času

Vědci zjistili, že náš mozek funguje jako počítač zkušeností. Na základě toho se nám zdá, že čas ubíhá rychleji nebo pomaleji.